- Retrait gratuit dans votre magasin Club

- 7.000.000 titres dans notre catalogue

- Payer en toute sécurité

- Toujours un magasin près de chez vous

- Retrait gratuit dans votre magasin Club

- 7.000.000 titres dans notre catalogue

- Payer en toute sécurité

- Toujours un magasin près de chez vous

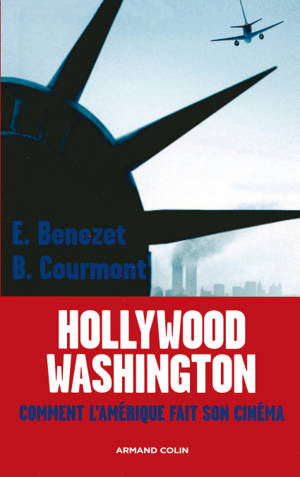

Hollywood -Washington EBOOK

Comment l'Amérique fait son cinéma

Erwan Benezet, Barthélémy Courmont

Ebook | Français

21,99 €

+ 21 points

Format

Description

Qui dirige vraiment les États-Unis, la politique ou le cinéma, Hollywood ou Washington ? La question est beaucoup plus sérieuse qu'il n'y paraît et la réponse qu'y apportent les auteurs de cette enquête originale et riche ne manquera pas de faire réfléchir. Le cinéma américain s'est toujours investi dans la vie politique, que ce soit pour participer aux grandes flambées patriotiques ou pour dénoncer les travers des administrations. Mais ce qui prend corps désormais, bien au-delà des cas Reagan ou Schwartzenneger, c'est une soumission croissante de la politique aux règles édictées par Hollywood. On ne mesure pas encore assez l'impact de ce renversement, qui marque l'avènement d'un avatar assez inquiétant de la "démocratie".

Spécifications

Parties prenantes

- Auteur(s) :

- Editeur:

Contenu

- Nombre de pages :

- 240

- Langue:

- Français

Caractéristiques

- EAN:

- 9782200254858

- Date de parution :

- 24-07-07

- Format:

- Ebook

- Protection digitale:

- Adobe DRM

- Format numérique:

- ePub